📌大数据开发面试简历撰写指南(含极简免费模板458款)| 精选2篇范文参考

OMG!面试大数据开发,简历怎么写才能脱颖而出?🤔 别慌!今天就手把手教你搞定!✍️ 从项目经验到技能亮点,一篇完美的简历能让你在众多候选人中闪闪发光!💡 快来一起学习吧,让你的简历成为HR的“心头好”!🔥💼 #大数据开发 #简历指南 #面试技巧

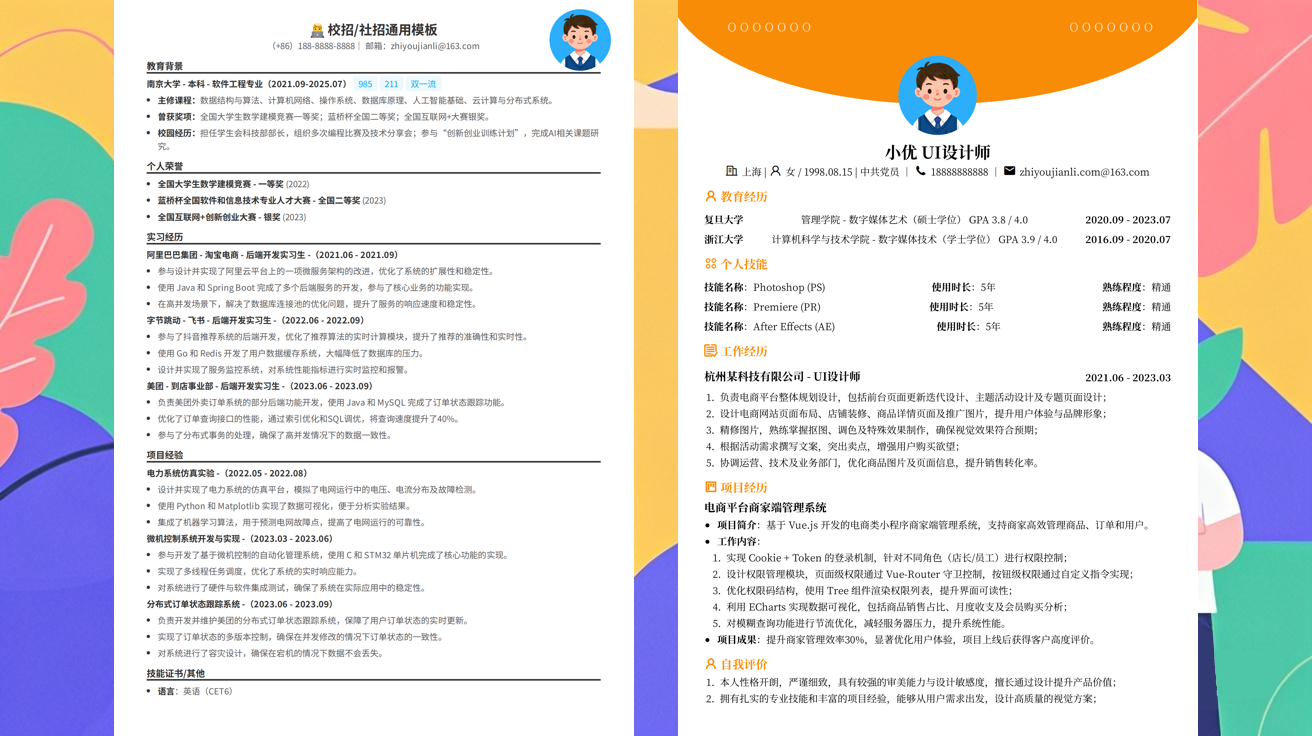

范文1

大数据开发面试简历撰写指南 | 简历范文分享📚✨

姐妹们!面试大数据开发岗位是不是有点懵?别慌!今天就来分享一篇超实用的简历撰写指南,附上范文参考,帮你轻松拿Offer!💼🚀

一、简历结构优化指南

一份优秀的简历,结构清晰是关键!👇

1. 个人信息区

- 姓名:顶格写,加粗!

- 联系方式:手机+邮箱,确保畅通!

- 求职意向:如“大数据开发工程师”,可加备注“Java/Scala方向”

2. 技能清单

- 硬技能:分点列出!如:

- 编程语言:Java (熟练), Scala (掌握), Python (基础)

- 大数据框架:Hadoop, Spark, Flink

- 数据库:MySQL, Hive, HBase

- 工具:Git, Docker, Kafka

- 软技能:可加少量描述,如“团队协作能力强”

3. 工作经历

- 时间倒序:最近的工作先写

- 公司名:加粗,行业关键词可选

- 职位:加粗

- 工作内容:用STAR法则写!Situation, Task, Action, Result

4. 项目经历

- 项目名称:加粗,突出亮点

- 项目描述:一句话概括项目核心

- 技术栈:分点列出

- 个人贡献:量化成果!如“优化查询效率30%”

5. 教育背景

- 学校+专业:加粗

- 时间:年月-年月

- 相关课程:可选,如“数据结构与算法”

二、简历内容优化指南

1. 大数据开发关键词

简历里一定要包含这些关键词!🔥

- ETL流程

- 数据清洗

- 离线计算

- 实时计算

- 数据仓库

- 数据可视化

2. 项目经历写法

- 突出技术深度:如“使用Spark SQL优化了100GB数据的ETL处理”

- 体现业务价值:如“通过Flink实时计算,提升了用户流失预警准确率”

- 展示解决问题的能力:如“解决过数据倾斜问题,并提出优化方案”

3. 量化成果技巧

- 用数字说话!如“处理数据量从500GB提升到5TB”

- 用百分比体现改进!如“响应时间从5秒缩短到0.5秒”

三、简历排版美观指南

- 保持简洁:一页纸内

- 重点突出:加粗、变色(可选)

- 间距合理:段落分明

- PDF格式:避免乱码

四、大数据开发简历范文

张三 | 大数据开发工程师

联系方式

📱 138****1234 | 📧 zhangsan@email.com

技能清单

硬技能

Java (熟练) | Scala (掌握) | Python (基础)

Hadoop | Spark | Flink

MySQL | Hive | HBase

Git | Docker | Kafka

软技能

团队协作 | 问题解决 | 数据分析

工作经历

XX科技有限公司 | 大数据工程师

2021.07 - 至今

负责公司核心业务数据的ETL处理,日均处理数据量5TB

主导搭建实时计算平台,提升数据处理效率40%

优化数据仓库结构,查询效率提升30%

YY数据服务有限公司 | 大数据开发工程师

2019.06 - 2021.06

参与电商平台数据平台建设,负责用户画像项目

使用Spark MLlib开发推荐算法,点击率提升25%

解决过数据倾斜问题,并提出优化方案

项目经历

电商平台实时用户行为分析系统

2020.05 - 2020.12

技术栈:Flink, Spark, Kafka, Elasticsearch

负责实时计算模块,处理用户行为日志

通过窗口函数优化,延迟从3秒降至1秒

公司内部数据仓库重构项目

2019.01 - 2019.06

技术栈:Hive, MySQL, Sqoop

优化分区表设计,查询效率提升50%

设计数据治理流程,规范数据质量标准

教育背景

XX大学 | 计算机科学与技术

2015.09 - 2019.06

主修课程:数据结构、算法设计、数据库原理

五、最后小贴士

- 针对性修改:每个公司侧重点不同,要调整关键词

- 保持真实:不要造假,面试会深挖

- 多投递:海投不如精投,但也要广撒网

祝大家面试顺利,拿到心仪的Offer!💖🎉

大数据开发 #简历技巧 #面试准备 #技术分享

范文2

大数据开发面试简历撰写指南 | 简历范文✨

姐妹们!面试大数据开发岗位是不是有点懵?🤯 别担心,今天就来分享一份超实用的简历撰写指南+范文,帮你轻松拿下心仪Offer!💼

📌 简历核心要点

1. 个人信息要完整

- 姓名、联系方式(电话+邮箱)、LinkedIn主页(如有)

- 可选:GitHub/个人技术博客链接(展示代码能力)

2. 技能清单要亮眼

- 大数据处理:Hadoop, Spark, Flink, Hive, HBase

- 编程语言:Java (必须!), Scala, Python

- 数据库:MySQL, PostgreSQL, MongoDB

- 机器学习:Spark MLlib, TensorFlow, PyTorch

- 云平台:AWS, Azure, GCP

- 版本控制:Git, SVN

3. 工作经历要具体

注意: 用STAR法则描述每个项目! - Situation (背景): 公司/团队是什么?你在什么角色? - Task (任务): 负责什么具体工作? - Action (行动): 使用了哪些技术?如何解决问题的? - Result (结果): 取得了什么量化成果?(如:提升效率30%,处理数据量增长50%)

4. 项目经验要突出

必须包含: - 项目名称+时间 - 项目描述(业务背景) - 技术栈(重点突出大数据相关) - 你的贡献(使用具体代码片段更佳) - 成果展示(可视化图表/数据量级)

💡 大数据开发简历写作技巧

- 量化成果:用数字说话最有效!

- "优化了Spark SQL查询性能,响应时间从5s降至1s"

-

"搭建实时数据流处理系统,处理能力达到10GB/s"

-

关键词优化:HR刷简历超快!

- 模糊查询、排序优化、分布式计算、数据仓库等

-

根据JD匹配关键词(用同义词替换避免重复)

-

项目逻辑要清晰:

- 从需求分析→技术选型→实现过程→上线效果

-

体现完整的工程思维

-

避免堆砌技术:

- 只写真正掌握的,每个技术点配实际案例

- 排序:核心技能在前(如Spark>Java>Hadoop)

🌟 简历范文示例

张三 | 大数据开发工程师 | 13800138000 | zhangsan@email.com

💪 技能清单

- 编程语言:Java (精通), Scala (熟练), Python (基础)

- 大数据生态:Hadoop (HDFS/MapReduce), Spark (SQL/Streaming), Flink (实时计算)

- 数据库:MySQL (主库开发), MongoDB (NoSQL), Hive (ETL)

- 云平台:AWS EMR, Azure HDInsight

- 工具:Git, Docker, Kubernetes, Zeek (网络分析)

🏢 工作经历

腾讯 | 大数据开发工程师 | 2020.07-至今

项目1:电商平台实时用户画像系统 - 负责用户行为数据的实时计算与特征工程 - 使用Flink 1.12实现毫秒级数据流转,处理峰值15万QPS - 优化Join操作,将延迟从3s降至0.5s,获评"技术之星"🌟

项目2:广告点击归因分析平台 - 设计ETL流程,整合TB级日志数据 - 开发Spark SQL UDF,实现跨表关联分析 - 支持AB测试自动计算,为业务决策提供数据支撑

百度 | 大数据开发实习生 | 2019.07-2020.06

项目:百度地图POI数据清洗系统 - 使用Java编写MapReduce程序,处理每日1000万条地理数据 - 开发规则引擎去重率提升至99.2% - 输出数据用于地图热力图渲染

🚀 项目经验

健康宝 | 智慧医疗数据平台 (个人项目)

- 时间:2021.05-2022.03

- 目标:整合医院电子病历数据,支持多维度分析

- 技术栈:Spark 3.1, Kafka, PostgreSQL

- 成果:实现患者画像可视化,获GitHub 320+Star

📚 教育背景

浙江大学 | 计算机科学与技术 | 2016.09-2020.06 GPA 3.8/4.0,曾获国家奖学金

💬 自我评价

| 技能 | 熟练度 |

|---|---|

| 分布式系统 | 🌟🌟🌟🌟 |

| 数据可视化 | 🌟🌟🌟 |

| 机器学习 | 🌟🌟 |

| 问题解决 | 🌟🌟🌟🌟 |

"对大数据充满热情,擅长从海量数据中发现价值,追求极致性能优化!"

✨ 最后Tips

- 简历控制1-2页最合适

- PDF格式投递,保留代码高亮

- 每隔3个月更新一次简历

祝大家面试顺利,拿到DreamOffer!💖 记得点赞收藏哦~

发布于:2025-11-12,除非注明,否则均为原创文章,转载请注明出处。

还没有评论,来说两句吧...