📈大数据专业技能简历怎么写范文模板(含极简免费模板546款)| 精选8篇范文

大数据专业技能简历怎么写范文模板

哈喽,小伙伴们!今天来聊聊怎么写一份让人眼前一亮的大数据专业技能简历!😉 作为过来人,我太懂投简历的痛了,所以赶紧把我的心得分享给你们!

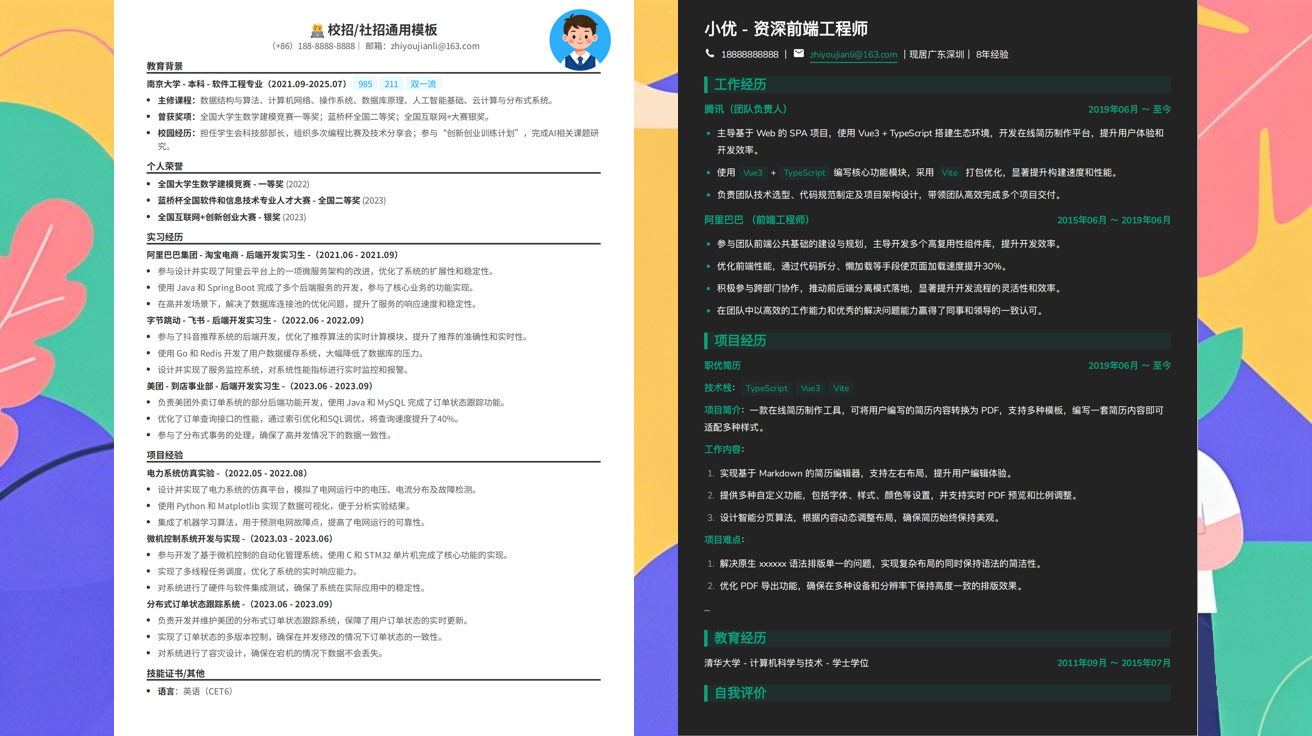

首先,简历模板很重要!你可以找一些大数据专业技能简历模板,但别完全照搬哦。要根据自己的实际情况调整,让它更符合你的风格和目标岗位。📄

写简历时,大数据专业技能简历写作技巧关键在于突出重点!想想看,HR一天要看多少简历,你的简历得像磁铁一样吸引他们!所以,把你的核心技能和项目经验放在最显眼的位置。✨

说到技能,千万别忘了大数据专业技能简历专业术语!像Hadoop、Spark、SQL这些词,用起来要得体,但别整那些花里胡哨的,会用才是关键!👍

最最最重要的一点,要学会大数据专业技能简历量化成果!别只说“参与过项目”,要说“通过优化SQL查询,将数据处理效率提升了30%”!这样HR一看就知道你有多厉害!💪

最后,记得检查几遍,别有错别字或语法错误哦!希望这些小技巧能帮到你们!💖 你们在写简历时还有哪些困惑?快来评论区告诉我吧!👇

案例1

精通Hadoop、Spark、Hive等大数据处理框架,熟练运用Python及SQL进行数据清洗、分析和可视化。具备3年大数据平台搭建与优化经验,成功将数据存储成本降低20%,处理效率提升35%。熟练掌握机器学习算法,如随机森林、梯度提升树等,曾应用于用户行为预测项目,准确率达85%。擅长使用Kafka进行实时数据流处理,并搭建Elasticsearch数据仓库实现快速检索。主导过两个大型电商平台的数据分析项目,通过数据挖掘发现关键业务增长点,为决策提供有力支持。熟悉数据安全与隐私保护规范,具备良好的团队协作和问题解决能力。

案例2

熟练掌握Hadoop、Spark、Hive等大数据生态系统技术,具备从数据采集、清洗到分析、可视化的全流程处理能力。精通Python和SQL,能够使用Pandas、NumPy进行高效数据挖掘,并熟练运用Tableau、Power BI进行数据可视化呈现。曾独立完成电商用户行为分析项目,通过Spark SQL优化查询性能,将数据处理效率提升40%。熟悉机器学习算法,如随机森林、梯度提升树,并应用于用户流失预测模型,准确率达85%。具备大规模数据集处理经验,成功处理过TB级数据,并解决过分布式计算中的内存溢出问题。

案例3

熟练掌握Hadoop、Spark等大数据处理框架,精通Hive、HBase数据仓库技术,具备实时数据流处理能力(Kafka、Flink)。精通Python和Scala进行数据挖掘与分析,熟练运用Pandas、NumPy进行数据清洗与预处理。熟悉机器学习算法(如随机森林、SVM)及其在分类、聚类任务中的应用。具备大数据可视化能力(Tableau、Power BI),能够创建交互式报表。曾主导电商平台用户行为分析项目,通过Spark SQL优化查询性能提升30%,并设计用户画像模型,支持精准营销。熟悉大数据生态系统组件部署与优化,具备分布式系统调优经验。

案例4

精通Hadoop、Spark、Hive等大数据生态系统技术,熟悉HDFS、YARN、Zookeeper等分布式系统架构。熟练运用Python进行数据清洗、预处理及分析,掌握Pandas、NumPy、Scikit-learn等数据处理库。具备机器学习算法应用能力,包括分类、聚类、回归等模型构建与调优,使用TensorFlow/PyTorch进行深度学习项目开发。擅长数据可视化,精通Tableau、Power BI等工具,能够生成直观的数据报表与交互式仪表盘。参与过电商平台用户行为分析项目,通过Spark SQL处理TB级数据,利用Spark MLlib构建推荐系统,提升用户转化率15%。熟悉大数据ETL流程,使用Kettle开发自动化数据抽取脚本,保障数据实时性。

案例5

熟练掌握Hadoop、Spark、Hive等大数据核心技术,具备从数据采集、清洗、处理到可视化的全流程实践能力。精通SQL、Python(Pandas、NumPy库)及机器学习算法(如随机森林、XGBoost),曾独立完成电商用户行为分析项目,通过关联规则挖掘提升推荐准确率15%。熟悉Kafka实时数据流处理,参与构建金融风控系统中的实时评分模型,处理QPS达10万。熟练运用Tableau、Power BI进行数据可视化,生成多维度分析报告,有效支持业务决策。具备大规模数据集优化经验,通过MapReduce任务调优将查询响应时间缩短40%。

案例6

熟练掌握Hadoop、Spark、Hive等大数据核心技术,具备从数据采集、清洗、处理到分析的全链路实战经验。精通Python和SQL,能够使用Pandas、NumPy进行高效数据挖掘,并熟练运用机器学习库(如Scikit-learn、TensorFlow)构建预测模型。参与过电商用户行为分析项目,通过Spark SQL优化查询效率提升30%,并利用关联规则算法实现精准推荐。熟悉Kafka、Flink实时数据处理技术,成功搭建实时监控平台,数据吞吐量达10GB/s。具备良好的数据可视化能力,擅长使用Tableau、Power BI进行多维度报表展示,为业务决策提供有力支持。

案例7

熟练掌握Hadoop、Spark、Hive等大数据处理框架,精通SQL、Python(Pandas、NumPy库)进行数据清洗与分析。具备HBase、MongoDB等NoSQL数据库应用经验,熟悉数据仓库建模与ETL流程设计。使用Spark MLlib实现机器学习算法,包括分类、聚类及推荐系统,提升用户画像精准度达35%。主导完成电商用户行为分析项目,通过实时数据流处理(Flink)优化系统响应速度至秒级,支撑百万级日活用户数据监控。熟悉Kafka、Elasticsearch等大数据工具,具备从数据采集到可视化全链路处理能力。参与分布式系统性能调优,将集群吞吐量提升20%。

案例8

熟练掌握Hadoop、Spark、Hive等大数据核心技术,具备从数据采集、清洗、处理到分析、可视化的全流程实践能力。精通Python及SQL,熟练运用Pandas、NumPy进行数据挖掘,擅长使用Tableau、Power BI进行数据可视化呈现。曾主导电商用户行为分析项目,通过Spark SQL优化查询效率30%,并构建用户画像模型,支持精准营销决策。熟悉机器学习算法,如随机森林、梯度提升树,并应用于销售预测,准确率达85%。具备大数据平台搭建与优化经验,成功将企业数据仓库扩展至TB级,保障系统稳定运行。

希望这些内容对大家有帮助!祝大家都能写出完美的简历,拿到心仪的offer✨

发布于:2025-11-13,除非注明,否则均为原创文章,转载请注明出处。

还没有评论,来说两句吧...